Igual han pasado más de 10 años desde que hicimos nuestro primer test A/B en Subelaweb. Qué ilusión, fue como si fuéramos científicos de laboratorio y estuviéramos buscando la cura de una enfermedad incurable. Estaba claro que si dábamos con la clave íbamos a cambiar el mundo…

Bueno, la verdad es que empezamos por cambiar un botón de color en una «landing page«, que me imagino que es cómo de párvulos de CRO (Conversion Rate Optimizer o esa persona que suele estar obsesionada con los tests A/B).

Después de muchos años desarrollando webs y proyectos de marketing online, ahora es cuando empezamos a entender el sentido de los tests A/B y empezamos a aplicarlos con un poco de criterio.

Hace poco estuve trasteando un curso de Udemy en el que Ruben de Boer, el CEO de Online Dialogue aportaba los conocimientos muy específicos de CRO. Algo bastante lógico viniendo de alguien que está totalmente focalizado en esa tarea y también de paso en divulgar todo lo que sabe. Se nota de verdad que es su pan de cada día (no como es mi caso). La verdad es que por mucho que nos interese o nos emocione la idea de obtener «un ganador», no podemos estar haciendo Tests A/B todo el día.

Viendo este curso me he dado cuenta (de nuevo) que no puedo ser especialista en todo. Eso sí, creo que podemos aprender de gente que si es muy especialista y extraer el conocimiento en un tiempo mucho más ajustado para poder seguir con nuestra vida.

Sin más rodeos os dejo alguna de las conclusiones que he sacado de cuándo merece la pena hacer un test A/B y cuando quizás es mejor dedicar tu energía a cualquier otra faceta de tu estrategia. Recordad el famoso «principio de Pareto» aplicado a la empresa que a mí me gusta recordarlo cada cierto tiempo. Un 20% del esfuerzo produce el 80% del beneficio.

¿Puedo hacer mi test A/B?

Pues la regla más genérica,»Rule of thumb» o regla del pulgar dice que para cada variación que se quiera introducir el test tiene que tener:

Al menos 1000 visitantes y/o 350 conversiones.

¿¿Es mucho??. Bueno, en la práctica lo que se necesita para que un test tenga sentido es que haya un aumento considerable en las conversiones en el sitio web.

Cuándo se supone que llega ese «aumento considerable», pues aquí Ruben de Boer nos dice:

Por cada 1000 conversiones de muestra, debes tener un aumento del 10% o más en el porcentaje de conversiones. Pero la realidad es que un aumento del 10% es un aumento muy grande y pocas veces se produce.

Por cada 10 mil conversiones de muestra bastaría tener un aumento del 1% o más en el porcentaje para que el test fuera relevante. Algo que es más alcanzable pero:

¿Tengo que tener 10 mil conversiones por poder dar por válida la muestra del test??? En fin, eso mismo me preguntaba yo y como norma general está claro que cuantas más conversiones y cuántas más visitas tengas en la muestra más sentido tendrá desde un punto de vista estadístico pero no hace falta llegar a tanto. Ahora os dejo una herramienta que te permite hacer un cálculo.

¿Una herramienta que se pueda usar para calcular el tamaño de la muestra?

En estadística todo depende del tamaño de la muestra. Para que algo sea representativo tenemos que haber realizado el estudio con una muestra que sea adecuada.

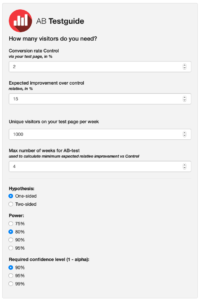

En el caso de los tests A/B hay os puedo dejar una herramienta de ABTESTGUIDE para calcular:

https://abtestguide.com/abtestsize/

Si queréis configurarla sin tener que saber mucho más, os dejo algunos valores que podéis marcar para el cálculo:

Primero tenéis que extraer de vuestra analítica estos datos:

- Conversion rate Control (el porcentaje de conversiones actual extraído de tu página web teniendo en cuenta el dispositivo y el segmento que queramos aplicar).

- Expected improvement over control o la «mejora esperada». Aquí con un 5% sería suficiente, no nos vengamos demasiado arriba).

- Unique visitors on your test page per week: dato de visitantes únicos también extraído de la web y del dispositivo y segmente de visitantes que elijamos.

- Hypothesis: One-sided.

- Power: 80%.

- Confidence level: 90% es suficiente.

- Expected improvement: 5% está ya bien.

Como veréis, al hacer los cálculos la realidad es que necesitáis muestras bastante elevadas de usuarios. También veréis que necesitas que el aumento de tasa de conversión sea bastante alto para que el experimento tenga sentido en un determinado periodo de tiempo. De hecho se recomienda que los test A/B no pasen de 4 semanas ya que por los problemas relacionados con las cookies y el seguimiento de visitas empiezan a no tener sentido.

En definitiva, podemos decir que para perder el tiempo en la elaboración de tests A/B tenemos que tener una página con muchas visitas y a ser posible con un nivel de conversiones aceptable. Parece algo lógico pero para tomar decisiones basadas en la estadística tenemos que tener claro que nuestro test se hace correctamente y que la hipótesis inicial es la adecuada.

A nosotros nos encanta la estadística y la analítica, e igual va con esa parte frikie que puedes llevar dentro pero sabemos que para jugar a hacer ciencia (aunque sean ciencias sociales) hay que ser metódico y aplicar las reglas.

Espero haberme explicado más o menos y si no es así os dejo el curso de CRO (en la vista previa del curso se explican estos conceptos 😉 ). Quizás podáis ayudarme apuntando algo que se me haya pasado o incluso algo que no haya entendido bien. Estamos para aprender…